Het is altijd goed om je limieten te kennen. Zeker als je in de wereld van de zoekmachine optimalisatie actief bent. Ontdek welke Google-limieten je zeker moet kennen en hoe je deze in je voordeel kan laten werken.

Je kan maximum 50.000 URL’s per sitemap indienen

Als je de luxe hebt om een website te beheren die meer dan 50.000 URL’s bevat dan ga je gegarandeerd op deze limiet stoten.

De limiet is vastgesteld op 50.000 URL’s en het sitemap-bestand mag maximaal 50 MB groot zijn. Het zou dus zeker kunnen dat je ook met minder dan 50.000 URL’s op deze limiet stoot.

Je zult een error in je Google Search Console krijgen en zal geadviseerd worden om je sitemap op te splitsen.

Je kan dit het best oplossen door een sitemapindex-bestand te maken in plaats van een gewoon sitemap-bestand.

Met een sitemapindex-bestand kan je een heel grote sitemap opsplitsen in kleinere sitemaps.

Als strategie zou je bijvoorbeeld per website-onderwerp een sitemap kunnen maken en deze oplijsten in je sitemapindex-bestand.

De robots.txt kan maximaal 500 kB groot zijn

Een website die goed scoort bevat unieke en uitgebreide informatie over meestal één goed gedefinieerd onderwerp. Als gevolg zal je website door tal van bots gescand worden. Dit kan voor ongewenste situaties zorgen.

Als er veel robots tegelijk je website scannen kan dit je website aanzienlijk doen vertragen. In sommige gevallen zelfs doen vastlopen.

Om dit te vermijden kan je aan de té enthousiaste bots te kennen geven dat je wil dat ze je website niet scannen of in golven met tussenpauzes bezoeken. Deze grenzen definieer je in het robots.txt-bestand van je website.

De maximale bestandsgrootte voor de robots.txt staat gelimiteerd op 500 kB. Door slim om te gaan met hoe je een blokkade voor een bot definieert kan je makkelijk onder deze limiet blijven.

Het opstellen van een robots.txt is echter niet zonder gevaar. Als je per ongeluk aan Google doorgeeft dat Google je belangrijkste pagina’s niet mag doorzoeken voor indexatie zullen deze pagina’s nooit in Google tevoorschijn komen. Ga zeker te rade bij een professional voor je je robots.txt aanpast of opstelt.

Je disavow-bestand kan maximaal 100.000 URL’s bevatten of kan een maximale bestandsgrootte van 2 MB hebben

Als je vermoedt dat je het slachtoffer bent van een negatieve SEO-campagne kan je inkomende links naar je website, die van websites komen die je niet vertrouwt, “disavowen” of in het Nederlands … afwijzen.

Je kan in zo een bestand tot 100.000 URL’s afwijzen. Of tot een bestandsgrootte van 2 MB.

Net als bij een robots.txt kan je ook hier door gebruik te maken van de juiste prefix een hoop regels uitsparen. Meestal ga je niet 1 URL afwijzen maar alle URL’s afkomstig van 1 spamdomeinnaam.

Beperk het aantal links op een webpagina tot enkele 1.000-den

Google raadt in haar Search Essentials aan om het aantal links op een webpagina te beperken tot maximaal enkele 1.000-den links.

Dit lijkt veel. En dat is het ook. We raden aan om het aantal links dat je op een pagina toont altijd zo laag mogelijk te houden. Het is eerder aan te raden het onder enkele 100-den te houden.

Zo vermijd je dat je website als een spamwebsite gezien wordt.

Een voorbeeld waarbij je enkele 1.000-den links op een pagina zou plaatsen zou zijn bij een oplijsting van onderdelen van een of ander apparaat.

Er is geen limiet op hoe vaak een website op de eerste pagina van Google getoond kan worden

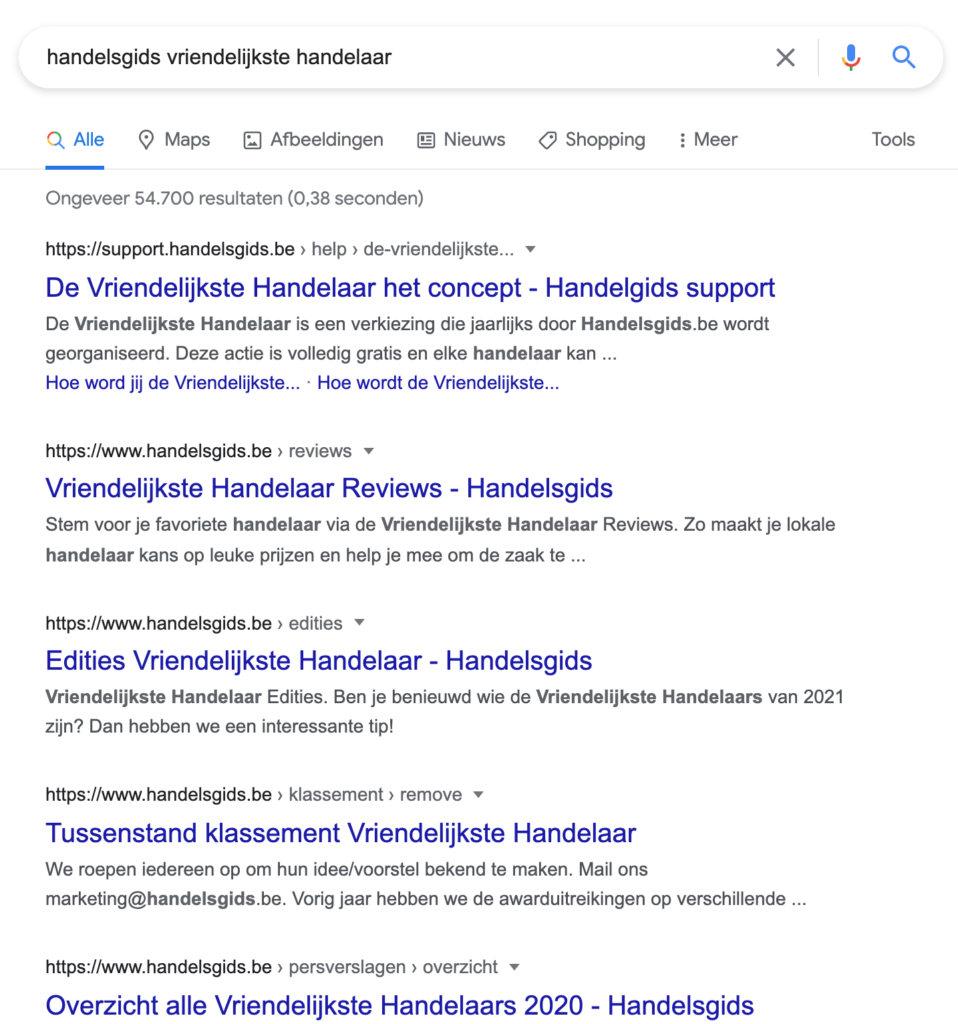

Jawel, het is mogelijk. Je website kan de volledige eerste pagina van Google inpalmen. Niet enkel positienummer 1.

Het is moeilijk, maar het is zeker te doen. Als je er voor zorgt dat je website zeer autoritair is over één onderwerp dan zal Google alle relevante pagina’s van je website tonen en je concurrenten naar de tweede pagina verbannen.

Hier een voorbeeld van een website waar we de SEO voor doen.

Laat een Kingmaker een SEO audit voor je doen en ontdek of jouw website de limieten overschrijdt

Het is belangrijk om te weten of je deze limieten al dan niet overschrijdt. Zo voorkom je slachtoffer te worden van manuele Google-penalty’s.

Het is ook mogelijk dat je jezelf limieten oplegt. Zo denk je misschien maar één van je pagina’s op de eerste pagina van Google te krijgen terwijl je de hele eerste pagina zou kunnen inpalmen.

Neem vrijblijvend contact met ons op voor de uitvoering van een SEO audit.

Zo zorgen we ervoor dat je een blitzstart neemt richting meer leads en bezoekers!

Leesvoer

Sitemaps

Robots.txt limiet

Links afwijzen

Google Search Essentials

Test Test Test Test Test Test Test Test Test Test Test Test Test Test Test Test Test Test Test Test Test Test Test Test Test Test Test Test Test Test Test Test